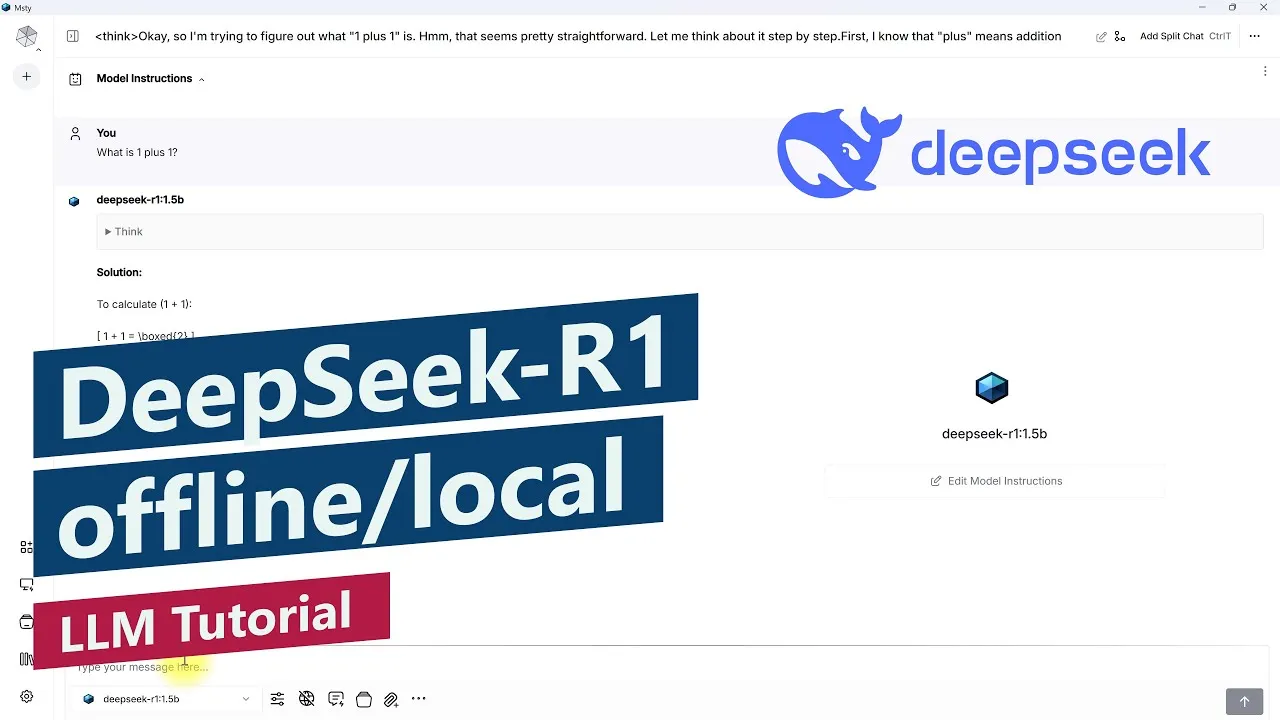

DeepSeek-R1 offline und kostenlos nutzen – LLM lokal installieren – Einfaches Tutorial für Anfänger

In diesem kurzen Tutorial zeige ich, wie man LLMs (Large Language Models) lokal auf deinem eigenen Computer installieren und damit offline und kostenfrei verwenden kann.

Ich zeige dies am Beispiel von DeepSeek-R1, was Anfang 2025 als ChatGPT-Killer Schlagzeilen machte.

Als Verwaltungsprogramm für die AI Models nutze ich Msty (msty.app), aber auch Alternativen wie LM Studio (lmstudio.ai) oder die Open-Source-Lösung Jan (jan.ai ) wären möglich.

Einfach herunterladen, installieren, ggf. updaten und dann direkt über dem Models Manager da gewünschte LLM herunterladen.

Danach noch die Arbeitsoberfläche einrichten und es kann mit dem Chatten losgelegt werden.

Die Geschwindigkeit hängt dabei vom gewählten Model und dessen Parametern ab, sowie von der eigenen Hardware. In meinem Fall ist es eine NVIDIA GeForce RTX 3060 Mobile mit 6 GB VRAM.

0:00 Intro

0:35 Msty installieren

1:00 Model herunterladen

1:55 Chat starten

2:25 Prompt eingeben

2:55 Outro

In dieser Anleitung spreche ich Deutsch. I speak German in this Tutorial.